2023年のChatGPT、言語モデルGPT4のリリースは、遂にAIの民主化を実現してくれました。

それから1年数カ月、日本時間2024年5月14日に、OpenAIは最新のAIプロダクトであるGPT-4oをリリースしました。その数日前から、GPT4の応答速度が早くなり、大きなアップデートが行われていることは予感していたものの、どのような新製品がリリースされるかの情報はありませんでした。

今回の記事では、OpenAIの最新のAIプロダクト「GPT-4o」について紹介します。

OpenAIのGPT-4oとは

日本時間2024年5月14日にOpenAIからリリースされた新プロダクトは「GPT-4o」です。数週間前まで、GPT5との噂もありましたが、リリース間近には「AI検索エンジンでもなくGPT5でもない」と報道されており、想像するのは困難だった「GPT-4o」。

この章で、紹介します。

読み方は「ジーピーティー・フォー・オー」

GPT-4oは、ジーピーティー・フォー・オーと発音します。オーはスモールのオーです。英単語「Omni」の頭文字で『すべての』を意味します。

これまでのOpenAIのプロダクトは、「GPT-3」、「GPT-3.5」、「GPT4」と大規模言語モデルが進化する系統を辿っていましたが、今回のGPT-4oは、単なる大規模言語モデルの進化ではありません。

音声・画像・テキストを統合的に読み取るモデル

GPT-4oは、単なる言語モデルの進化ではなく、テキスト応答の精度は変わっていません。

従来のテキスト認識(一部、音声認識)に加えて、人間の直接的な音声や画像、動画もプロンプトとして送信でき、GPT-4が認識・応答するというモデルになっています。

ChatGPTは、すでに音声入力に対応していましたが、レスポンスは他メーカーのスマートスピーカーと変わらないレベルに落ち着いていました。これは、音声をテキストに変換する技術そのものは、既存の音声認識とそれほど変わらないことを意味しています。

圧倒的な速度で人間と会話するGPT-4o

今回のGPT-4oは、実際の人間との会話と変わらないレベル、かつ音声入力されたプロンプトを、自然言語に近い抑揚を含めた音声で返すことが可能になりました。

従来のようにテキストでプロンプトを送信することも可能ですが、人と会話するように、完全な音声だけで受け答えができるのです。

元々、ChatGPTはAGI(汎用人工知能)の路線で開発されたAIモデルであり、一般人でも使えるプロダクトとして存在していましたが、より汎用性が高まり、人とAIの共存という世界観に近づきました。

GPT-4oを使うためには

ChatGPT自体は無料で使えますが、最上位の言語モデルであるGPT-4は有料ユーザーのみに限定されていました。今回のGPT-4oはどのようなプランで提供されているのか。

この章で紹介します。

無料プランでも提供予定

今回のGPT-4oの発表では、GPT-4もGPT-4oも、今後、無料で使えるとされています。ただし、機能や回数は当然、制限されるものと思います。

現時点で、GPT-4やGPT-4oの無料枠については、OpenAIから詳細の発表はありませんので、続報を待ちましょう。

実際のGPT-4oを少し紹介

当サイトでは、2023年のGPT-4のリリース以降、継続して有料プランに加入しています。GPT-4oも現時点で使えるようになっていますので、実際の使用感も紹介します。

iPhone版のChatGPTアプリを使用

基本的に、PCやタブレットなどのブラウザからChatGPTにアクセスしても、大きな違いはありませんが、今回はiOSで提供されている「OpenAI公式のChatGPTアプリ」を利用しています。

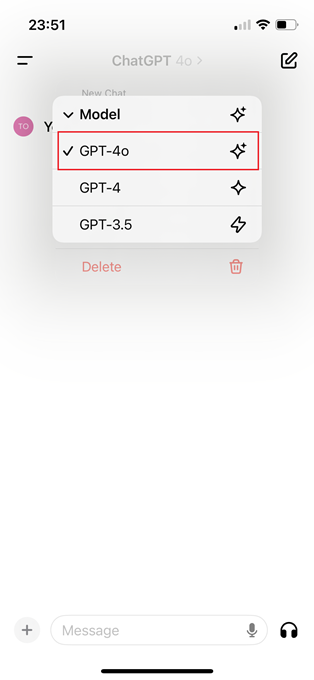

有料プランに加入していれば、下記のようにモデルの選択で「GPT-4o」が追加されており使うことが可能です。

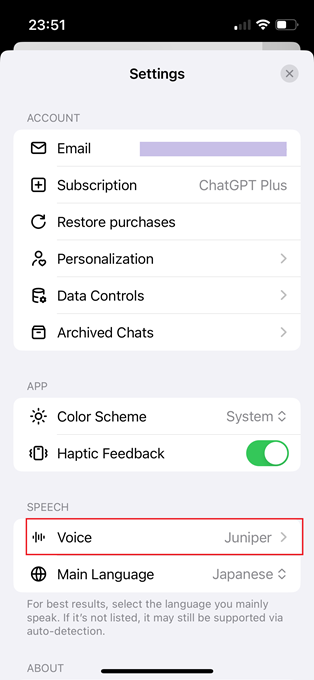

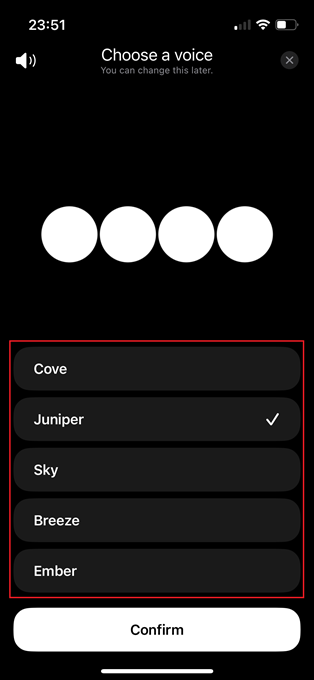

また、ChatGPTで音声入力が可能になった時期から搭載されていたかもしれませんが、ChatGPTのSettingsメニューに「Voice」が追加されており、Cove,Juniper,Sky,Breeze,Emberの5つの音声から選択することが可能です。

それぞれ、声質の異なる男性・または女性の疑似音声です。

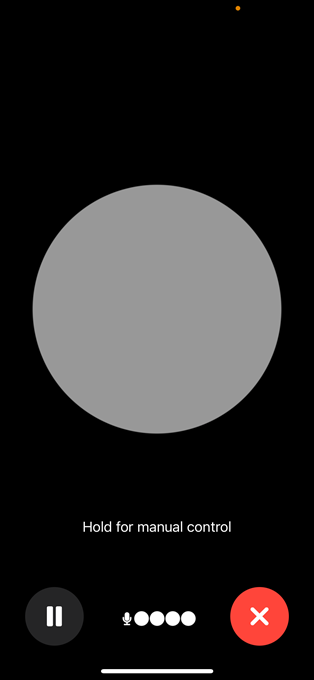

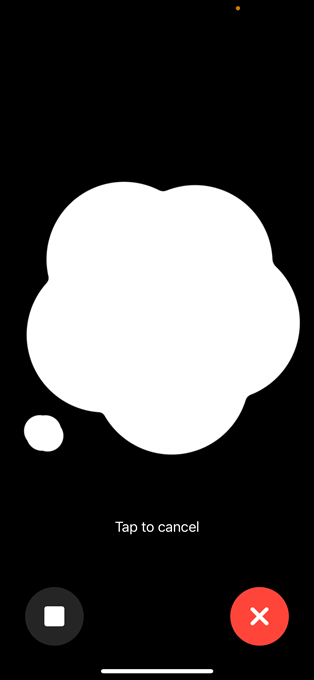

音声入力画面です。人が話している間は、グレーの円形が表示されており、音声入力が途絶えると白い雲のようなイラストに切り替わり、音声の認識が始まります。

なお、話始めや話の終わりごとに画面をタップする必要はなく、自動で聞き取ってくれます。この会話時には、AirPodsを使うこともできますので、スマホをバッグ等から出さずに会話が可能です。

GPT-4oの会話性能の検証

当サイトで検証したのは、2024年5月13日、つまりGPT-4oのリリース当日です。実は、何度もGPT-4oとの会話を試みたのですが、単純な音声入力でも、下記のエラーメッセージが発せられるだけで検証することはできませんでした。

おそらくリリース当日の夜間のため、世界中で新機能が試されてOpenAIのシステムに大きな負担がかかっているのでしょう。具体的な検証は、後日、公開することにします。

動画の認識性能について

GPT-4oは、音声や画像、テキストのほか、動画も認識することが可能と発表されています。

実際に、ChatGPT-GPT-4oのプロンプト入力画面で、動画をアップロードすることもできたのですが、うまく認識してくれませんでした。

結構、デタラメな回答が返ってきましたので、動画認識については、まだ調整中のようです。

あとがき

今回は、世界中が注目するOpenAIの最新のAIプロダクト「GPT-4o」のリリースに伴い、現時点で把握している情報を記事に纏めました。

GPT-4oの目玉機能である「人間との自然な会話」は、充分な検証結果が得られませんでしたが、引き続き検証を続けて有益な情報を発信していきます。

2023年のAIの民主化からわずか1年強でリリースされたGPT-4oは、驚異の可能性を持っています。

従来の問い合わせ用テキストのボットから、AIによる音声の会話が実現し社会導入された場合、ファーストフードのドライブスルーシステム、コールセンターの問い合わせ、高齢者やメンタルケアの話相手など、活躍が見込める分野は計り知れません。

個人専用の優秀な家庭教師にもなり得ます。

同時に、AGI化が急速に進むにつれ「AIと倫理問題」も急速に顕在化するでしょう。

あらためて、AIの進化に驚かされる1年になりそうです。